|

| Google Gemma AI Model |

في الآونة الأخيرة، قدمت Google أول نموذج مفتوح المصدر للذكاء الاصطناعي يسمى Gemma بحجمين، Gemma 2B و7B. يعتبر النموذج مناسبًا للمهام الإبداعية باللغة الإنجليزية مثل إنشاء النص والتلخيص والتفكير الأساسي وما إلى ذلك. نظرًا لصغر حجمه، يمكن تنزيل النموذج واستخدامه محليًا على جهاز كمبيوتر منخفض الموارد دون اتصال بالإنترنت. إذن، إليك برنامجنا التعليمي لتنزيل نموذج Google Gemma AI وتشغيله على أنظمة التشغيل Windows وmacOS وLinux.

تنزيل نموذج جوجل جيما 2B

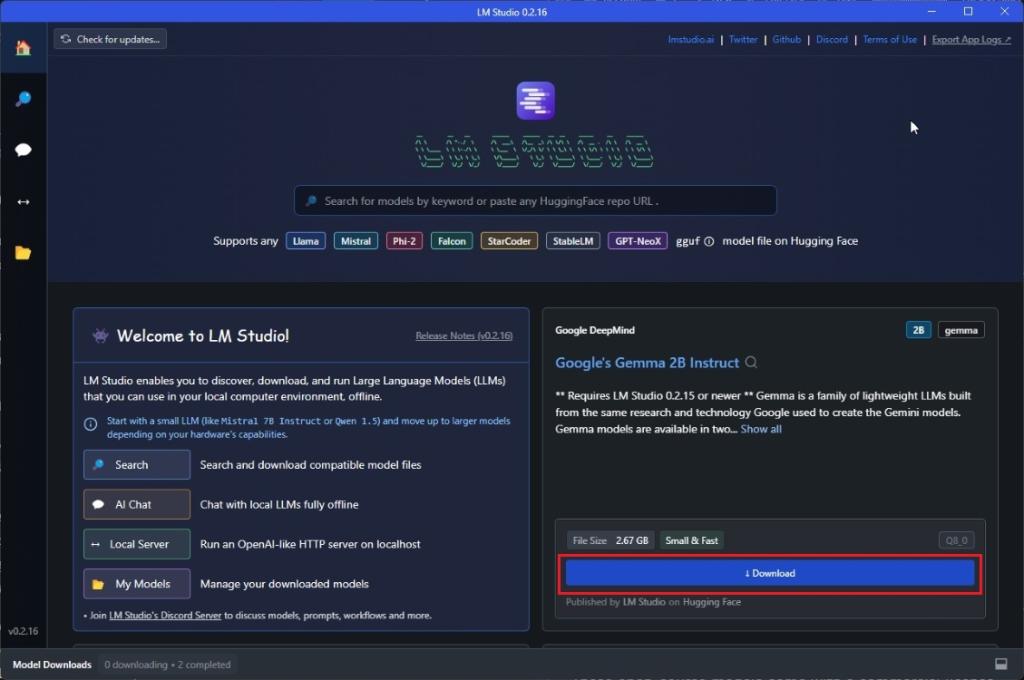

- تابع وقم بتنزيل LM Studio ( مجاني ) على جهاز الكمبيوتر الخاص بك. بعد ذلك، قم بتشغيل البرنامج.

- ستجد في الصفحة الرئيسية نموذج " Google's Gemma 2B Instruct ". يمكنك أيضًا البحث يدويًا عن "Gemma". الآن، افتحه.

- بعد ذلك، ما عليك سوى النقر على "تنزيل". إنه ملف بحجم 1.5 جيجابايت حيث تم تكميم نموذج Gemma 2B بمقدار 4 بت لضغط حجم النموذج وتقليل استخدام الذاكرة. إذا كان لديك ذاكرة وصول عشوائي (RAM) تزيد عن 8 جيجابايت، فيمكنك تنزيل النموذج الكمي 8 بت (2.67 جيجابايت) الذي سيوفر أداءً أفضل.

قم بتشغيل Google Gemma دون اتصال بالإنترنت باستخدام LM Studio

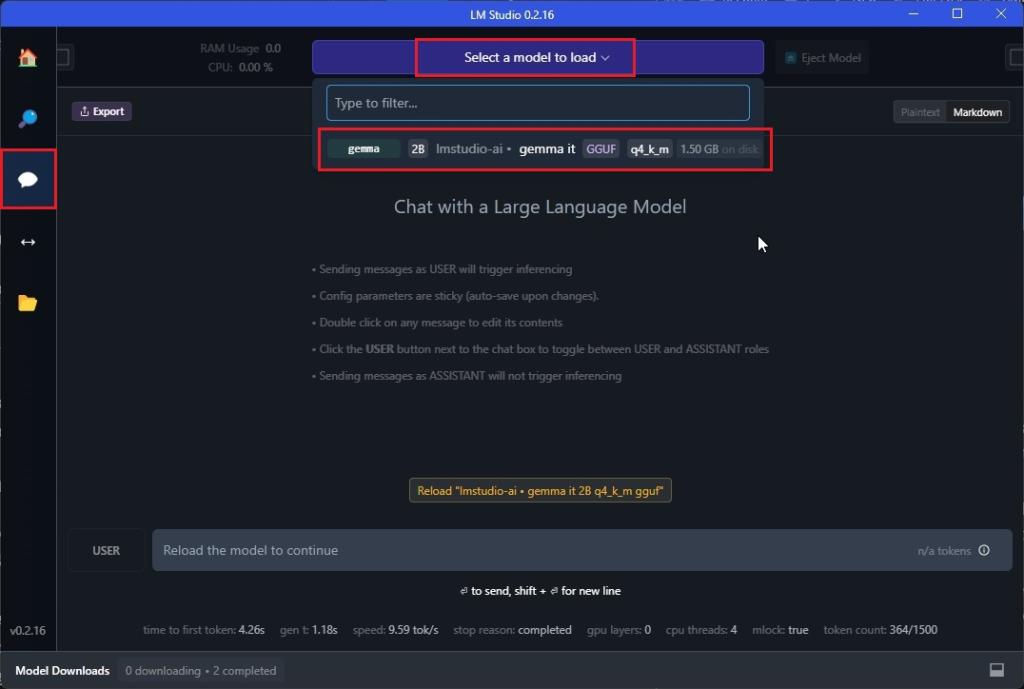

- في LM Studio، انتقل إلى نافذة " الدردشة " على الجانب الأيسر.

- بعد ذلك، انقر فوق " تحديد نموذج للتحميل " واختر "جيما". سيستهلك حوالي 1.4 جيجابايت من ذاكرة الوصول العشوائي.

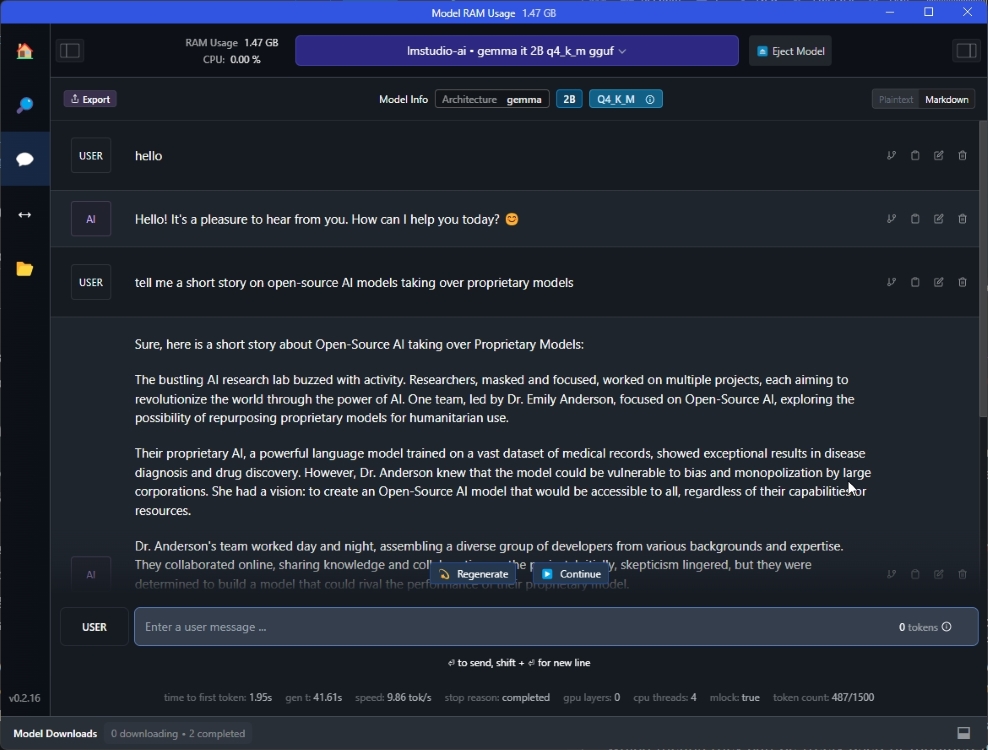

- الآن، تفضل واطرح أسئلتك . من خلال تجربتي، يعتبر نموذج 2B Gemma الصغير مناسبًا للمهام الإبداعية في اللغة الإنجليزية. إنه يرفض الإجابة على أي شيء ذي قيمة حيث يتم طلب الرأي حول أي موضوع (على سبيل المثال، هل لغة C أفضل من Rust؟).

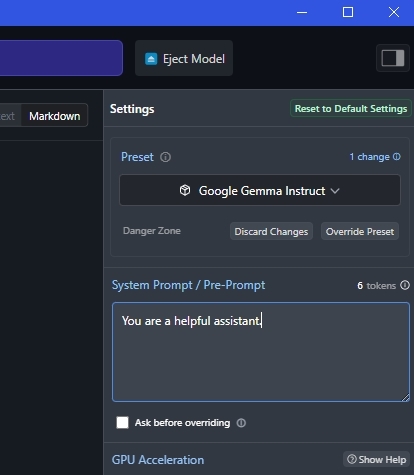

- يمكنك أيضًا تعيين موجه النظام على اليمين لتخصيص سلوك نموذج الذكاء الاصطناعي.

إذن هذه هي الطريقة التي يمكنك بها تنزيل نموذج Gemma من Google وتشغيله على جهاز الكمبيوتر الشخصي وجهاز Mac وLinux. على الرغم من أنني أجد نموذج جوجل مفتوح المصدر لطيفًا للغاية ، إلا أنه قد يكون مفيدًا للأشخاص الذين يبحثون عن نموذج ذكاء اصطناعي بسيط لتشغيله محليًا.

على أية حال، هذا كل شيء منا. إذا كنت تبحث عن مساعد ذكاء اصطناعي محلي حقيقي، فإنني أوصي بشدة بمراجعة Open Interpreter . إنه يعمل مثل مترجم Code Interpreter الخاص بـ ChatGPT ويقوم بمهام فعلية على جهاز الكمبيوتر الخاص بك. أخيرًا، إذا كانت لديك أي أسئلة، فأخبرنا بها في قسم التعليقات أدناه.